在計算機的世界中,CPU(中央處理器)和GPU(圖形處理器)是兩個耳熟能詳的詞匯。隨著AI技術的認讀,作為最重要硬件支持之一,GPU變成了AI、加密貨幣、科學研究等領域的“新寵”,甚至引發全球爭搶,身價暴漲。作為計算機性能的核心組件之一,GPU的性能優劣也直接影響著計算機在圖形處理、游戲運行、視頻渲染等多方面的表現。

那么,為什么算力支持現在在炒GPU,而不是CPU?為什么GPU近年來突然“爆紅”?今天,就帶大家了解一下關于GPU的基本知識~

GPU:圖形處理小能手

什么是GPU?

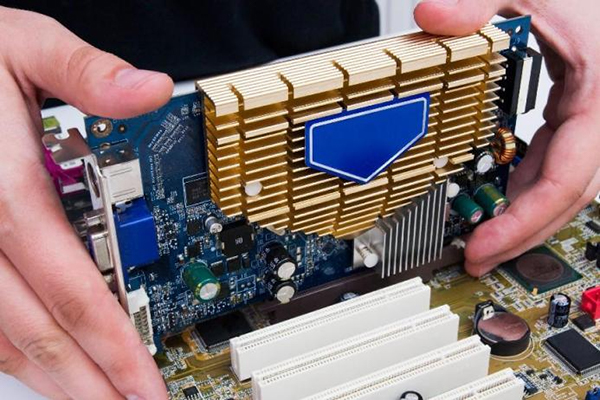

GPU英文全稱為Graphics Processing Unit,即圖形處理單元(圖形處理器),它是顯卡的核心部件,最初的使命是處理圖形渲染——比如游戲里光影、爆炸、建模等復雜畫面。在生活中,人們常常把GPU和顯卡的概念混為一談,實際上,顯卡除了GPU之外,還包括顯存、供電模塊、散熱器、風扇和各種接口(如顯示接口、通訊接口、供電接口等等)。它們之間是不能畫等號的。GPU的主要特點有核心數量多、并行處理能力超強、適合處理海量相似的任務等。

GPU的歷史

20世紀90年代末,隨著游戲和多媒體業務的蓬勃發展,人們對計算機的3D圖形處理和渲染能力提出了更高的要求。傳統CPU雖然功能強大,但在處理這些圖形密集型任務時顯得力不從心。1999年,英偉達(NVIDIA)公司推出了被廣泛認為是第一款真正意義上的GPU的GeForce 256芯片,每秒至少能處理1000萬個多邊形。這款芯片讓計算機圖形處理工作完全不依賴CPU,而是在這款獨立的芯片上完成。其運算速度比CPU快2-4倍,有效減輕了CPU的負擔,大幅提升了計算機的圖形處理能力。就這樣,GPU時代來臨了。

GPU與CPU傻傻分不清楚 誰是圖形處理的王者?

CPU和GPU都是計算機中的重要組成部分,但它們在功能和設計架構上有著顯著的區別。

CPU全稱是Central Processing Unit(中央處理單元),自計算機誕生以來就是運算核心。作為通用計算芯片,它負責指令解析、任務調度、邏輯判斷、系統控制,是整個設備的大腦。而作為并行計算芯片,GPU則具備強大的并行計算能力,對靈活性要求較低,善于將復雜的數學計算變為大量簡單和重復的任務,且GPU無法單獨工作,需要被CPU調度管理。

從設計架構上來看,無論是CPU還是GPU,任何處理器內部都由3部分組成,即算術邏輯單元(核心ALU/CORE)、控制單元(CONTROL)以及緩存(CACHE)。而CPU和GPU這三部分的架構占比完全不同。

CPU的核心數較少(通常2~64個),但每個核心功能豐富,能力較強。CPU擁有大量的緩存和復雜的邏輯控制單元,適合處理各種復雜的任務。當程序擁有多個分支的時候,控制單元通過分支預測的能力來降低執行延遲。

而GPU包含成百上千個較小、更高效的核心,這使得GPU在處理視頻游戲、三維動畫、圖形設計和視頻編輯等視覺密集型任務時表現卓越。GPU的控制單元也相對簡單,圖形渲染的高度并行性,使GPU可以通過簡單增加并行處理單元和存儲器控制單元的方式,提高處理能力和存儲器帶寬。

簡單來說,CPU更擅長復雜邏輯的運算,而GPU構架相對簡單,但運算核心多,適用于大量邏輯簡單但高并發量的高密度計算。

簡單類比一下,如果CPU是一個廠長,GPU就是一整個車間的工人隊伍。每個工人可能能力不強,但一起動手效率驚人!

雖然CPU和GPU在功能和設計上有所不同,但它們之間并不是非此即彼的關系。在現代計算機中,CPU和GPU通常協同工作。CPU負責處理各種復雜的任務和邏輯判斷,而GPU則專注于圖形處理任務。這種協作模式使得計算機能夠在保持高性能的同時,還能有效地降低功耗。

AI與GPU

GPU從圖形計算拓展至通用計算

將GPU應用于圖形之外的計算,最早可追溯到2003年。彼時,隨著計算機圖形復雜度不斷提升以及半導體技術的持續進步,GPU開始被用于通用計算(General Purpose computing on GPU,簡稱GPGPU),應用場景涵蓋科學模擬、數據分析和機器學習等領域。開發者借助專門的編程框架,如CUDA或OpenCL,通過編寫可在GPU上執行的代碼,利用其并行架構加速計算,使GPU本質上成為能同時處理多個計算任務的硬件加速器。

2006年,英偉達推出CUDA(Compute Unified Device Architecture,計算統一設備架構),讓GPU在通用計算領域嶄露頭角,開始在科學模擬、金融分析和深度學習等領域發揮關鍵作用。深度學習尤其依賴GPU強大的并行處理能力,來進行大規模的矩陣和向量計算。

2012年,谷歌大腦(Google Brain)團隊成員Jeff Dean和吳恩達等通過深度學習技術,斥資100萬美元,成功讓16000臺電腦學習1000萬張圖片后,在YouTube視頻中“認出”了貓。

神經網絡之父杰弗里·辛頓(Geoffrey Hinton)知道這件事后,認為如果利用GPU進行神經網絡訓練,則不需要消耗這么多資源。

于是他和自己的兩個學生亞歷克斯·克里切夫斯基(Alex Krizhevsky)、伊利亞·蘇茨克沃(Ilya Sutskever),利用“深度學習+GPU”的方案,推出了深度神經網絡模型“AlexNet”,其使用2個基于CUDA的GPU,進行神經網絡訓練,是第一個錯誤率低于25個百分點的模型。該模型也一舉贏得Image Net大規模視覺識別挑戰賽(ILSVRC)的冠軍。

這次比賽后不久,谷歌大腦又將CPU替換成GPU,重新進行了讓計算機識別一只貓的實驗。實驗結果發現,僅用16臺電腦的64個GPU,就能達到之前相同的效果。

AlexNet的推出,進一步推動了GPU在AI深度學習領域的廣泛應用。此后,GPU在AI領域的應用還獲得了生態支持。英偉達等公司建立了基于自家GPU的CUDA生態系統,提供完善的開發環境和方案,助力開發人員更便捷地使用GPU進行深度學習開發或高性能運算。

AI青睞GPU的原因

如今,在AI計算領域,GPU的地位從“邊緣配角”走向了科技舞臺中央的原因在于在其深度學習的過程需“投喂”大量數據,這個過程需要進行大量矩陣相乘、卷積等運算,GPU憑借自身強大的并行計算能力和內存帶寬恰好能夠很好地應對這些任務。在合理優化的情況下,一塊GPU卡所能提供的算力,相當于數十臺至上百臺CPU服務器。

當然,在AI計算中,并非只有GPU“獨領風騷”。FPGA(現場可編程門陣列)和ASIC(專用集成電路)等計算芯片在AI領域也有廣泛應用。它們各有優勢,FPGA靈活可編程,適合快速迭代和原型開發;ASIC則針對特定算法進行優化,性能更高、功耗更低。但無論如何,GPU在AI領域的地位都不可撼動。

經過上述內容的介紹,想必你對GPU已經有了初步的認識。如果說過去50年是CPU的天下,那么未來50年,GPU也許才是真正的主角。但這并不意味著CPU退出舞臺,而是人類已經進入了一個“多計算架構協同”的新時代。

今天,我們用CPU瀏覽網頁、編輯文檔,用GPU啟動AI應用、訓練模型,用FPGA和NPU執行特定算法。計算正在成為一種更靈活、更智能的服務,就像水、電一樣流淌在我們生活中。

展望未來,隨著科技的持續革新與飛速發展,GPU的性能必將迎來更為顯著的飛躍,能效比也將得到進一步優化提升。屆時,它將為各類復雜的應用場景提供更為強勁、高效的支持,助力我們在數字世界中暢行無阻。

未來的“算力戰爭”,才剛剛開始。

參考資料:

1. 鳳凰網:《華裔科學家竟然用AI識別喵星人?》;

2. 阿里云:《什么是GPU?》;

3. 云計算科普研究所blibili:【什么是GPU?十分鐘帶你了解GPU的前世今生!(GPU與CPU的區別)》《硬核解析》從GPGPU到CUDA,看完秒懂GPU為何主宰AI !】;

4. 鮮棗課堂:《AI計算,為什么要用GPU?》。